原因は不明だが、SwitchBotアプリ(iOS版)でエアコンなどを操作しようとしたら読み込み中のまま戻って来なくなる現象が出ていた。色々試した結果、湿温度計のファームをv2.5からv2.6に上げたら直った。ただ、色々やってるので本当にこれが原因かは不明。

p.s. 2022/1/2

うーん、今度は2021/12/29 20:14以降のデータが表示できなくなった。。。なんだろう。

HUB miniを電源再投入したら直りました。。。

原因は不明だが、SwitchBotアプリ(iOS版)でエアコンなどを操作しようとしたら読み込み中のまま戻って来なくなる現象が出ていた。色々試した結果、湿温度計のファームをv2.5からv2.6に上げたら直った。ただ、色々やってるので本当にこれが原因かは不明。

p.s. 2022/1/2

うーん、今度は2021/12/29 20:14以降のデータが表示できなくなった。。。なんだろう。

HUB miniを電源再投入したら直りました。。。

Windows に嫌気が差したときに時々使っているubuntu desktop環境を放っておいたらうっかりサポート期限が切れて通常のリポジトリから消えてしまった。。。そのままではメンテナンスバージョンへのアップデートもできないのでなんとか、19.10が残ってるサイト内かとミラーサイトを探したのですが、どこにもない(同期されてしまっている模様)

そんな中、ありがたい記事発見。なるほど、old-releasesというサイトが用意されてるのね。これもありがたい。

さくっと /etc/apt/sources.list のdeb http://jp.archive.ubuntu.com/ubuntu/ をhttp://old-release.ubuntu.com/ubuntu/ に変えて sudo apt update、sudo apt upgrade、 sudo do-release-upgrade で20.04 TLSに上げられました。

ちなみに http://security.ubuntu.com/ubuntuは何に変えたらいいのかよくわからんのでコメントアウトしておいたが、問題なくアップデートできた。(残しておくとエラー出る)

先日、gcpから「[Action Required] To continue receiving your Free Tier discount, upgrade your F1-Micro VM to an E2-Micro VM by September 1, 2021」というタイトルのメールが届いた。

gcp ではアメリカの一部のリージョンでf1-microをずっと無料で利用できるのですが、そのインスタンスがe2-microに変更されるようです。

f1-microは0.2vCPU、0.6GBメモリだったのですが、e2-microは0.25vCPU、1.0GBメモリに増強されるようです。まぁ、使ってみた感じは正直差を感じられませんでしたが(笑)メモリが増えた分、swapは少し減りましたかね。

まぁ、元々f1-microではパワー不足なのでg1-small検討してねと出てるので、仕方ないんですけどね(笑)

p.s.

現時点(2021/8/4)で、free Tierがe2-microになったことは書いてないですね。

https://cloud.google.com/free/docs/gcp-free-tier?hl=ja

それと、e2-microのFree Tierの課金がちょっとおかしいみたいです。何故か微妙に課金されていておかしいなぁと思っていたら、以下のメッセージが出てました。

| 3 Aug 2021 | 15:31 PDT | Summary: Mutliregional Price for E2 Free Tier core is set incorrectlyDescription: Customers in us-west1 and central1 creating E2-micro VMs are being incorrectly charged. Our engineering team have a mitigation underway.Mitigation progress is expected by Tuesday, 2021-08-03 17:30 US/Pacific.We will provide more information by Tuesday, 2021-08-03 17:30 US/Pacific.Diagnosis: Customers might see that they’re being incorrectly charged for a general purpose e2-micro VMs.Workaround: None at this time. |

TS-230にリプレースしたので、バックアップジョブを作り直したのだが、残念ながらTS-269Proのバックアップジョブで作ったバックアップリポジトリをそのまま使うことはできなかった。

TS-230で新たに、バックアップジョブを作るときに、既存のS3内に同名フォルダがあるとジョブを作成できない。

バックアップ先のS3設定は後から変えられない。ストレージクラスを変えようと思ったらバックアップジョブ作り直し。そうするとバックアップデータも引き継げないので注意。

間違えてInteligent-Tieringを選んでしまって、そのせいで1か月以内にファイルを消したら(ライフサイクルで1日後にGlacier Deep Archiveに移動してるので)結構な額を取られた。。。

https://aws.amazon.com/jp/s3/pricing/

S3 Intelligent Tiering、S3 標準 – IA、S3 1 ゾーン – IA のストレージには、最低 30 日間のストレージ料金が課金されます。30 日が経過する前にオブジェクトが削除された場合、その 30 日の残りのストレージ料金が日割りで請求されます。30 日が経過する前にオブジェクトが削除されたり、上書きされたり、別のストレージクラスに移行されたりした場合、通常のストレージ利用料金に加えて、その 30 日の残りのリクエスト料金が日割りで請求されます。

気を付けましょう。。。

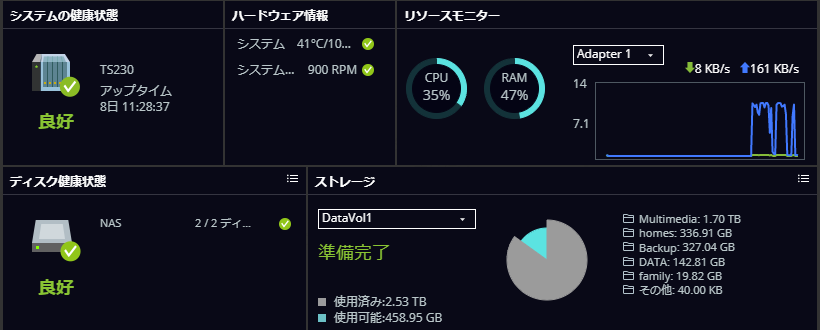

QNAP TS-269Proも購入して7年経過してるのでそろそろ壊れてもおかしくないということで、リプレース。

QNAP to QNAPのリプレースの場合、Intel系からIntel系への移行ならHDDを差し換えるだけで移行できる。ただ、その場合はHDDの中はそのままなので、後から追加されたスナップショット機能とかは使えない。

TS-269Proを買った時は自宅にESXiサーバがあってそのバックエンドストレージとしても使っていたので、ちょっといいやつを選んでいたが、今は単なるデータ置き場なので、TS-230(ARM系)に変更することにした。TS-269Proが55,000円だったのに対し、TS-230は19,900円。

https://www.amazon.co.jp/gp/product/B083ZKQMFW/ref=ppx_yo_dt_b_search_asin_title?ie=UTF8&psc=1

Intel系からARM系に変更するときは基本的に設定しなおし、データはコピーして移行する必要がある。

と言っても、QNAPなので、大して設定するところもないので、ユーザ作って、グループ作って、共有作ってHBS3(Hybrid Backup Sync 3)でフォルダー間同期ジョブを作って同期するだけ。簡単です 🙂

ついでに、消費電力を考え、今回は HDDを2.5インチに変更した。HDDはTOSHIBA MQ04ABB400R (4TB)を選択。Amazon で整備済み品を買ってみた。(問題があってリペアした製品?)1か月使ってみたが特に問題なし。

https://www.amazon.co.jp/gp/product/B08D5CJQSQ/ref=ppx_yo_dt_b_search_asin_image?ie=UTF8&psc=1

家庭使いでは十分な性能な感じ。ただ、ちょっと気になるのがHDDの交換の仕方。Hot Swapには対応してるのだけど、構造がイケてなくて、持ち上げて底のネジを外してトップカバーを外さないとHDDを交換できない。これ。。。事故る気がする(笑)

TS-230はGooglePhotos有料化対応 で書いたQuMagieにも対応しているので試してみた。実はこれがやってみたくて今リプレースしたという噂も(笑)

が、ちょっと、GooglePhotosやAmazon Photosの様な使い勝手の良さはない感じ。

動作感: もっさり。まったり。インデックス化や人物判別などはQNAPのJOBとして実施するのですが、これがすごい掛かるのと、モバイルアプリの作りが良くないのか操作の時の応答性が良くない。

人物判定精度:かなりアバウト。GooglePhotosに比べると同じ人物を別人と判断することが多い。WEB UIから同一人物だよ。別人だよ。と教えてあげることは可能。

GooglePhotosが6/1より有料化するので、身辺整理を(笑)

まず、GooglePhotosがどうなるのかを確認。

ってことですね。2021/6/1以前に上げた写真や動画と、それ以降の写真や動画の容量をどうやって管理するのか気になりますが、こういった要件になります。

https://japan.cnet.com/article/35162321/

という訳で、まずはゴミ掃除。とにかくGoogleドライブ内のゴミを消してみよう。

「保存容量」をクリックすすと何がどのくらい容量を使っているか出るのですが、なんだこのisoファイルは(笑) 速攻消します。

確かに、一時期Googleドライブで同期してた時期があったような。今は使ってなくて、消しても良いということなので、速攻削除!

消して、ゴミ箱を空にしても保存容量はすぐには反映されない模様。(1時間ほど経ってから見たら更新されてました)

さて、ようやく本題。どんだけGoogleドライブを整理してオもGooglePhotosを使う限り15GBは超えてしまうので、選択肢を考えねば。私の場合この3つかな。

という訳で調べてみたところQuMagieってのがなんかかっこいい!

でも、私の古いQNAP(TS-269Pro)は対象外みたい。。。

https://www.qnap.com/ja-jp/software/qumagie

私のQNAPでも使えるPhoto Stationって機能もあるんだけど、共有をメインに考えてるソフトで検索って意味だとやっぱりQuMagieかな。まぁ、QNAPを買い替える時はちょっと考えるとして。

まぁ、やっぱり、普段使いはAmazon Photosを使いつつ、写真、動画全体のバックアップはQNAPにQFILEでバックアップ。がいいかな。

貧乏根性でバックアップディスクの設定を「このドライブを圧縮してディスク領域を空ける」を選んでみたのですが。。。

まず、データが入った状態でやるとスゲー時間が掛かります。そして、圧縮はファイル単位で行われ圧縮している間一時的に2倍の容量を食います。。。

つまり、1ファイルでディスクサイズの半分以上の領域を食ってるようなファイルは圧縮できないという訳ですね。。。なんか、ファイルコピー中にまだ半分容量が開いてるはずなのにいっぱいだと言われて気づきました。。。

2012サーバ移行で追加された記憶域領域の重複排除とかはブロック単位でやってくれているので大丈夫なんですけどねぇ。

まぁ、諦めてそのままコピーします。はい。

iTunesのバックアップに掛けたパスワードがどうしても解らなくなってしまい。。。調べた結果こんな記事を発見

https://qiita.com/wakaoys/items/7734b4e2c969420abfb8

普通のPCでやってたらとんでもない時間が掛かってしまい使い物にならないわけですが、AWS使ってP3でぶん回せば行けるのでは!?

https://www.akimbocore.com/article/hashcracking-with-aws/

こんな記事も見つけました。

私はubuntu 20.04で試しましたが問題なく動きました。

なお、NVIDIA-Linux-x86_64-440.33.01.runのインストールはNVIDIAデバイスがないと失敗します。私はコスト面を考えてそれ以前の準備はt2.microで実施しました。作ったAMIをp3.16xlargeで起動してクラックを実施します。また、コストが安い、us-east-1(バージニア北部リージョン)のスポットインスタンスで起動しています。ちなみに、Pインスタンスはデフォルトでは4vCPUまでしか起動できない制限が掛かっているのでAll P instances制限緩和申請する必要があります。さらにスポットインスタンスとして起動しようとするとMax spot instance count exceededと言われて起動できないのでEC2 スポットインスタンスp3.16xlarge:1で申請しました。サポートレベルがBasicのせいか、スポットインスタンスの制限緩和申請に3営業日程かかりました。スポットインスタンス制限緩和は平日9:00-18:00対応だそうです。。。

hashcatは最新は6.1.1の様なので、以下から最新のバイナリを入手しました。

手元のi3-6300TのマシンのWSLで2428 H/sくらいでした。p3.16xlargeでは2891.1kH/sだそうです。まぁ、おおよそ1000倍と言ったところでしょうか。7桁で13時間くらいと出てました。

幸いヨワヨワパスワードだったので、1時間ちょいで解けてしまいました (^o^;)/ 怖

かかった費用

p3.16xlarge Linux/UNIX Spot Instance-hour in US East (N. Virginia) in VPC Zone #7 1.641 Hours $12.06

時間単価 7.35USDくらいですかね。オンデマンドだと24.48USD/時間なので、スポットだと7割引。素晴らしいです。

オンプレにあったメールサーバ(冗長構成)をAWSに移行したときに危なかった話。

オンプレのロードバランサでは一般的にソースNATはしないと思いますが、AWSのELB(CLB)はソースNATしてしまいます。例えば、PostfixなどでMynetworksにローカルIPが許可されてると、思いっきりサードパーティリレーされてしまうので気を付けましょう 🙂

そしてちゃんとサードパーティリレーチェックしましょう。有志によるこんなサイトもあるので、ご活用ください。

http://check.jippg.org/

サイトは普通に見えているし証明書エラーも出ていないのですが、JetPackの接続時に “cURL error 60: SSL certificate problem: certificate has expired”と言われて接続できない。もちろん証明書の期限は切れていない。

色々調べた結果、安い証明書を使っているので、中間証明書を入れないといけなかったようだ。Ubuntu 20.04の場合こんな感じ。中間証明書は証明書を買ったところに行けば入手できると思います。

$ sudo vi /etc/apache2/sites-enabled/default-ssl.conf SSLCertificateChainFile /etc/ssl/certs/lambeden_dyndns_org.ca $ sudo systemctl restart apache2